Ataki adwersarialne jako ciche zagrożenie dla systemów Sztucznej Inteligencji

W dobie powszechnej implementacji algorytmów uczenia maszynowego (ML – Machine Learning) w kluczowych sektorach gospodarki, od autonomicznych pojazdów po systemy diagnostyki medycznej, bezpieczeństwo modeli AI staje się priorytetem. Dokument Typy ataków na Sztuczną Inteligencję rzuca światło na jedno z najbardziej wyrafinowanych zagrożeń: ataki adwersarialne (Adversarial Attacks). Czym są, jak działają i dlaczego mogą doprowadzić do destabilizacji systemów o wysokim znaczeniu?

Czym jest atak adwersarialny?

Atak adwersarialny to technika polegająca na wprowadzaniu subtelnych, niemal niezauważalnych dla człowieka zmian w danych wejściowych, które mają na celu oszukanie modelu AI. Choć dla ludzkiego oka obraz czy dźwięk wydają się niezmienione, dla algorytmu stają się nośnikiem błędnych informacji. Jest to bezpośredni atak na integralność systemu, wymuszający na modelu podjęcie błędnej decyzji lub dokonanie niewłaściwej klasyfikacji.

Słynny „eksperyment”atak na AI”: Gdy panda staje się gibonem

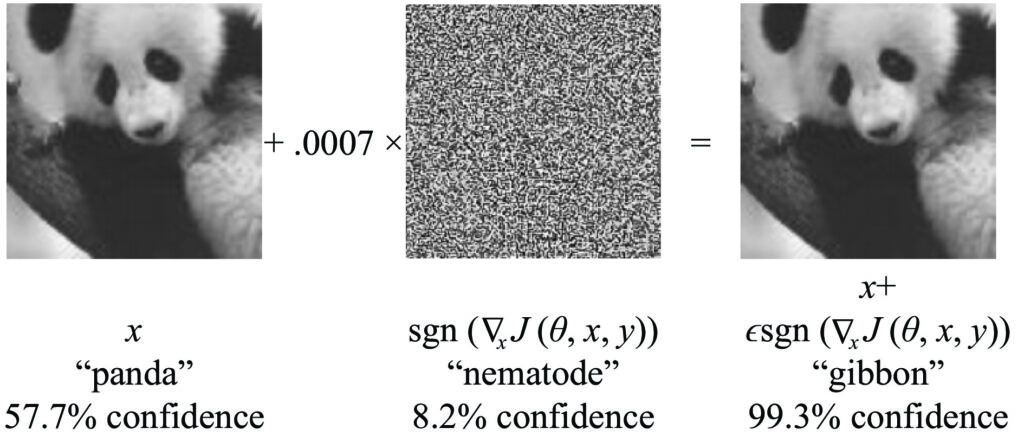

Klasycznym już przykładem, który wstrząsnął światem badaczy AI, jest manipulacja obrazem pandy, który został przedstawiony w artykule Explaining and harnessing adversarial examples, który opublikowali w 2015 roku badacze Google’a: Ian J. Goodfellow, Jonathon Shlens and Christian Szegedy. Badacze wzięli zdjęcie pandy, które model rozpoznawał ze średnią pewnością (Confidence – 57,7%). Następnie nałożyli na nie minimalny szum cyfrowy – warstwę zakłóceń, która dla ludzkiego oka była absolutnie niedostrzegalna.

Efekt? System wizji komputerowej (Computer Vision), który wcześniej widział pandę, nagle z 99,3% pewnością stwierdził, że na zdjęciu znajduje się… gibon.

Ten przypadek udowodnił, że AI nie „widzi” świata tak jak my. Algorytmy opierają się na matematycznych gradientach, a precyzyjnie wymierzony „szum” potrafi wypchnąć dane poza granice poprawnej klasyfikacji, nie zmieniając przy tym wizualnego odbioru zdjęcia przez człowieka.

Główne mechanizmy manipulacji AI

Zgodnie z klasyfikacją zagrożeń, możemy wyróżnić trzy kluczowe rodzaje ataków, które uderzają w różne etapy życia modelu:

1. Ataki omijające (Evasion Attacks)

To najczęstszy typ ataku, przeprowadzany już po wdrożeniu modelu. Atakujący modyfikuje dane wejściowe (np. dodając cyfrowy szum do zdjęcia), aby system je błędnie zinterpretował.

- Przykład: Znak STOP na koszulce, który system autonomicznego auta odczytuje jako nakaz zatrzymania się.

- Skutek: Destabilizacja operacji i zagrożenie życia lub mienia.

2. Zatrucie modelu (Model Poisoning)

Ten atak następuje na etapie uczenia lub aktualizacji parametrów. Polega na manipulowaniu wagami i strukturą modelu w taki sposób, aby w określonych warunkach zwracał on błędne wyniki.

- Cel: Wprowadzenie ukrytych podatności, które mogą zostać aktywowane przez atakującego w przyszłości (tzw. backdoors).

- Skutek: Utrata poufnych danych i całkowita manipulacja procesem decyzyjnym.

3. Zatrucie danych (Data Poisoning)

Różni się od zatrucia modelu tym, że uderza w zbiór treningowy. Atakujący wstrzykuje złośliwe dane do bazy, na której uczy się AI, co trwale wypacza jej logiczne wnioskowanie.

Dlaczego Adversarial AI jest groźne dla systemów o wysokim znaczeniu?

Systemy o wysokim znaczeniu (tzw. high-stakes systems) to takie, których błąd ma katastrofalne skutki. Wykorzystanie ataków adwersarialnych w takich obszarach jak bankowość, energetyka czy obronność może prowadzić do:

- Błędnych decyzji finansowych: Ominięcie filtrów anty-fraudowych przez zmanipulowane wnioski kredytowe.

- Awarii infrastruktury: Przejęcie kontroli nad systemami sterowania procesami przemysłowymi.

- Paraliżu służb: Oszukiwanie systemów biometrycznych i rozpoznawania twarzy.

Jak się bronić? Strategie odporności

Ochrona przed takimi atakami wymaga spojrzenia na temat z wielu perspektyw. Dokument Typy ataków na Sztuczną Inteligencjęwskazuje na kilka kluczowych metod defensywnych:

- Adversarial Training (Trening adwersarialny): Polega na włączaniu zmanipulowanych przykładów do zbioru treningowego. Model uczy się rozpoznawać próby oszustwa i staje się na nie odporny.

- Mechanizmy detekcji: Implementacja dodatkowych warstw monitorujących, które analizują dane wejściowe pod kątem nienaturalnych anomalii i szumów.

- Optymalizacja i czyszczenie: Techniki optymalizacji modelu, które usuwają zbędne parametry, ograniczając tym samym pole powierzchni ataku.

- Ograniczanie dostępu: Ścisła kontrola nad tym, kto może odpytywać model, co utrudnia atakującym przeprowadzenie tzw. inżynierii wstecznej (kradzieży parametrów).

Ataki adwersarialne to nie tylko teoretyczne zagadnienie naukowe, ale realne wyzwanie dla współczesnego cyberbezpieczeństwa. W miarę jak AI przejmuje coraz więcej odpowiedzialności za nasze życie i bezpieczeństwo, zrozumienie mechanizmów takich jak Evasion Attacks czy Model Poisoning staje się niezbędne dla każdego inżyniera i menedżera IT. Kluczem do sukcesu jest budowanie systemów, które są odporne z założenia (secure-by-design), a nie tylko reaktywne wobec znanych zagrożeń.